جوجل تعزز خصوصية نماذج التعلم الآلي في منصة (TensorFlow)

من شأن الإضافة الجديدة أن تساعد المطورين على تعزيز حماية الخصوصية في نماذج التعلم الآلي وضبط تسرب بيانات التدريب باستخدام أسلوب يسمى هجمات استخلاص العضوية.

مصدر الصورة الأصلية: جوجل | تعديل: إم آي تي تكنولوجي ريفيو العربية

أعلنت جوجل يوم 24 يونيو عن إطلاق إضافة تجريبية لمجموعة أدوات الخصوصية في منصتها تنسرفلو (TensorFlow) الخاصة بتطوير نماذج التعلم الآلي، وهي إضافة تتيح للمطورين إمكانية تقييم درجة الخصوصية في نماذج التعلم الآلي والسيطرة بشكل أفضل على تسرب البيانات. وتأمل جوجل أن تشكِّل هذه الأدوات أساساً لتطوير حزمة اختبار الخصوصية التي يمكن لجميع المطورين استخدامها بغض النظر عن مستوى مهاراتهم.

لا توجد حتى الآن قواعد محددة فيما يتعلق بتطوير نماذج ذكاء اصطناعي تحافظ على خصوصية البيانات، لكن العديد من الدراسات تشير إلى إمكانية تسرب أجزاء حساسة من بيانات التدريب عبر هذه النماذج.

وقد كانت منصة تنسرفلو تتعامل مع هذه المسألة باستخدام تقنية الخصوصية التفاضلية التي تتيح إمكانية إضافة بعض التشويش إلى البيانات، بحيث لا يمكن تطبيق أدوات الهندسة العكسية للتعرّف على هوية أشخاص محددين، غير أن من شأن هذا التشويش أن يؤثر على دقة النموذج.

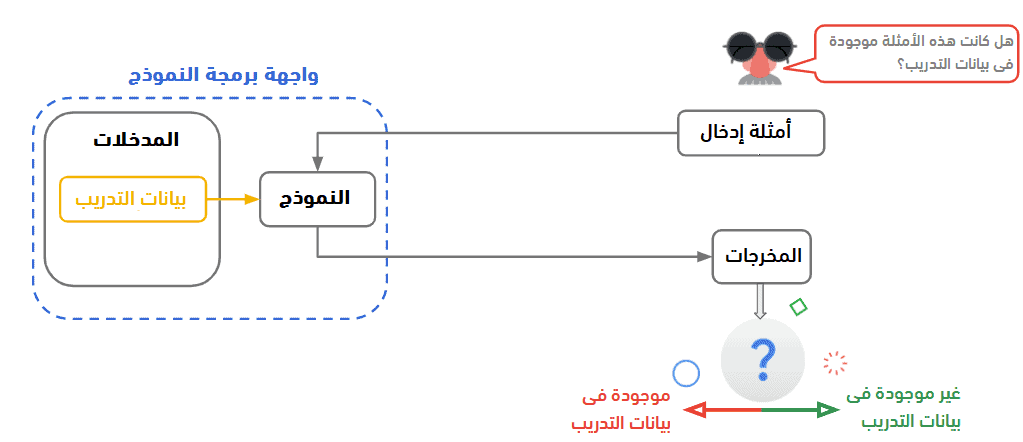

وفي مسعى من جوجل لحل هذه المشكلة، لجأت اليوم إلى استخدام أسلوب يسمى “هجمات استخلاص العضوية”. وينطوي هذا الأسلوب على بناء خوارزميات قادرة على استنتاج ما إذا كانت عينة محددة موجودة في مجموعة بيانات التدريب. وكلما ارتفعت دقة استنتاج الخوارزمية، كان نموذج الذكاء الاصطناعي أقلّ حماية للخصوصية.

وقد قال فريق تنسرفلو في منشور مدونة إن أهم ما يميز هذا الأسلوب هو استخدامه لمُخرجات النموذج فقط ودون الحاجة إلى الوصول إلى أوزان النموذج أو عينات الإدخال. كما أنه لا يتطلب إعادة تدريب النموذج، مما يجعل تنفيذه سهلاً ولا يستغرق وقتاً طويلاً.

وأشارت الشركة في إعلانها إلى أن الاختبار الجديد يعطي درجة للنموذج تشير إلى مدى تسريبه لبيانات التدريب. وأكدت أن استخدام تقنية الخصوصية التفاضلية إلى جانب أسلوب هجمات استخلاص العضوية يساعد في تخفيض هذه الدرجة وبالتالي توفير حماية أكبر للبيانات.